Comparaisons de consommations de l’IA

Introduction : un coût énergétique élevé et souvent méconnu

L’intelligence artificielle (IA) transforme tous les secteurs… mais à quel prix ? Derrière la promesse de modèles toujours plus performants se cache une réalité énergétique souvent occultée : entraînement massif, centres de données surchauffés, données stockées en continu. Ce sont autant de sources de consommation corroborées par de nombreuses études.

1. Les sources principales de consommation

Entraînement des modèles

Le deep learning nécessite un apprentissage long et gourmand en ressources. Selon Deloitte, l’entraînement d’un modèle de grande taille consomme entre 324 et 1 287 MWh, soit l’équivalent de 36 à 144 foyers américains en un an Deloitte.

Centres de données (data centers)

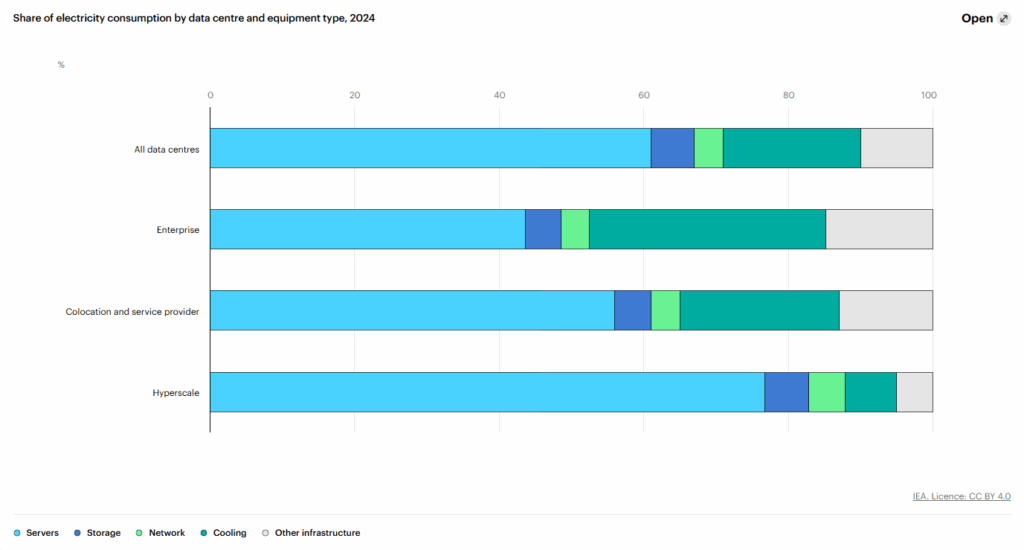

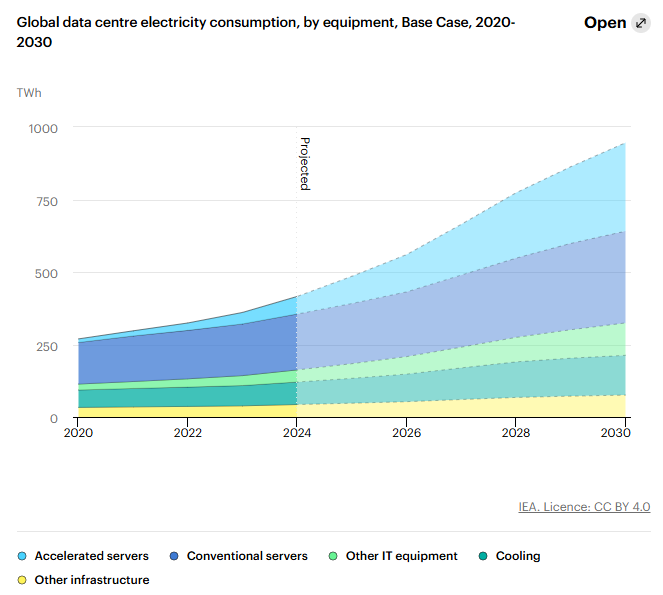

L’IA fonctionne 24/7 dans des centres. Les données de l’Agence internationale de l’énergie (IEA) estiment que les data centers consomment 415 TWh en 2024 (≈ 1,5 % de la consommation électrique mondiale), et pourraient doubler pour atteindre environ 945 TWh en 2030 AIE – Agence Internationale de l’Énergie.

Ce chiffre inclut les serveurs, le stockage, le refroidissement (jusqu’à 30 %) et l’infrastructure de support.

2. Chiffres concrets : consommation, eau, émissions

a) Consommation électrique de modèles emblématiques

- GPT‑3 (175 milliards de paramètres) : entraînement estimé à 1 287 MWh, soit 552 t CO₂ rebootmonkey.com+4Green Queen+4Medium+4.

- BERT : 1 507 kWh pour la version de base (≈ 1,44 t CO₂) Le Monde+233RDSquare+2Wikipédia+2.

- BLOOM (176 Md paramètres) : émission de 24,7 tonnes de CO₂, ou 50,5 tonnes en incluant la fabrication arXiv+1Wikipédia+1.

- GPT‑4 : selon Baeldung, l’entraînement a consommé environ 1 750 MWh (~ 912 t CO₂) Baeldung.

Comparatif de la consommation énergétique annuelle de GPT-3 et GPT-4

| Comparaison | GPT-3 (1 095 000 kWh/an) | GPT-4 (1 825 000 kWh/an) |

|---|---|---|

| Équivalent en foyers français | ≈ 233 foyers (4 700 kWh/an) | ≈ 388 foyers |

| Équivalent en km en voiture électrique | ≈ 7,3 millions de km (15 kWh/100 km) | ≈ 12,2 millions de km |

| Émissions de CO₂ (approx.) | ≈ 328 tonnes CO₂ (0,3 kg CO₂/kWh) | ≈ 547 tonnes CO₂ |

| Vols Paris–New York (aller-retour) | ≈ 78 vols (≈ 4,2 tonnes CO₂ / vol AR) | ≈ 130 vols |

| Ampoules LED 10 W allumées 8h/j | ≈ 37 700 ampoules (29 kWh/an chacune) | ≈ 62 900 ampoules |

b) Eau et refroidissement

- Formation de GPT‑3 : environ 700 000 litres d’eau évaporés dans les centres Microsoft Green Queen+1Le Monde+1.

- Un data center de 100 MW peut utiliser 2 000 000 L d’eau par jour, soit la consommation de ~ 6 500 foyers Wikipédia+3Wikipédia+3Financial Times+3.

- Selon les experts, d’ici 2030, les data centers consommeraient jusqu’à 1 000 TWh d’électricité, soit ~ 4,5 % de la production mondiale TechRadar+6The Guardian+6Hugging Face+6.

3. Impacts environnementaux

a) Émissions de CO₂

- Data centers représentent actuellement 1–3 % des émissions de gaz à effet de serre mondiales Medium.

- L’AI inference (exploitation) représente 60 à 90 % de l’empreinte carbone totale, d’après Google, Meta et Amazon Wikipédia+4DitchCarbon+4Medium+4.

- Selon un rapport du FMI, les émissions liées à l’IA pourraient ajouter 1,3 à 1,7 Gt CO₂ entre 2025 et 2030, l’équivalent de la pollution de l’Italie sur cinq ans Axios.

b) Empreinte carbone comparable

- Entraîner GPT‑3 équivaut à 123 voitures parcourant toute une année Green Queen+1Wikipédia+1.

- Le ventilateur des data centers libère autant de chaleur que des centrales thermiques. D’ici 2040, 14 % des émissions mondiales pourraient provenir des centres de données arXiv+6deloitte.wsj.com+6reddit.com+6.

4. Estimations et tendances futures

L’étude IEA prévoit que la consommation des centres de données pourrait grimper jusqu’à 945 TWh en 2030, et atteindre 970 TWh en 2035 (~ 2,6 % de la demande globale) Financial Times+2AIE – Agence Internationale de l’Énergie+2Medium+2.

Le FMI estime que la demande électrique liée à l’IA pourrait atteindre 1 500 TWh d’ici 2030, à comparer à la consommation actuelle des data centers Axios.

5. Solutions et initiatives pour une IA plus sobre

a) Optimisation logicielle

- Pruning, quantization, distillation réduisent la taille des modèles sans trop nuire à la performance. Par exemple, DistilBERT offre ~ 95 % de la précision pour moins de 40 % de la taille du modèle complet.

b) Matériel et refroidissement

- Adoption de puces spécialisées (TPU, GPU haute efficacité) et de technologies de refroidissement avancées (liquid cooling, free-air cooling) MediumDitchCarbon+3TechRadar+3Medium+3.

- Modèles de centres de données modulaires ou « vert » comme HP EcoPod, qui réduisent drastiquement la consommation électrique Wikipédia.

c) Hébergement vert

- Les géants (AWS, Azure, Google Cloud) visent une énergie 100 % renouvelable d’ici 2030 Medium.

- L’IEA promeut la formation des IA dans des zones où l’énergie est bas carbone pour réduire les émissions .

d) IA frugale et locale

- TinyML et modèles “edge” traitent les données à la source, limitant les appels aux serveurs distants.

- Approche « Small AI » pour des tâches spécifiques, plus sobres en énergie.

e) Régulation et sensibilisation

Conclusion

L’IA ouvre des perspectives fascinantes, mais à un coût écologique non négligeable : eau, énergie, rejets carbone. Les prévisions montrent que sans intervention, la consommation liée à l’IA pourrait représenter jusqu’à 1 500 TWh et plusieurs gigatonnes de CO₂ d’ici la fin de la décennie.

Pour éviter cela, des réponses techniques et organisationnelles existent : optimisation des modèles, hébergement vert, usage local, et régulation éclairée. En combinant innovation et responsabilité, l’IA peut rester un levier de progrès… sans sacrifier l’avenir de la planète.